智能驾驶座舱如我们之前文章讲到,他让汽车不简单是一个让你从A移动到B的工具,而是变成懂人类,能与人类互动的智能设备,车内交互可以提高驾驶员的情境意识、信任、舒适性、更好的用户体验以及可用性和安全性。当前汽车从按键交互跨越到了车载显示交互,未来传统车载显示器预计将扩展到具有多模式界面的图形用户界面 (GUI) 显示器,如我们之前文章所诉配备了多种传感技术包括听觉、触觉/触觉、手势、可穿戴传感器、和 AR/VR /混合现实 (MR) 技术,以确保准确预测车内交互。此外,驾驶员或乘客监控对于交互至关重要。车载交互系统需要估计和推断驾驶员/用户的动作、疲劳或困倦等状态、驾驶员的认知状态以及用户的情绪。

通常,人类可以隐式和显式地与智能车辆进行交互。在隐式交互中,用户或驾驶员根据自己的权利进行他们的行为,观察者(汽车)可以推断出用户执行某些行为的状态或意图。例如驾驶员疲劳识别、情绪识别,甚至可以向智能车辆传达某些线索的姿势或姿势估计。

相反,用户打算主动的与车辆进行通信,这就是显式交互例如包括语音命令(了解语言控制汽车AI智能语音101及其供应链)、手势以及通过触觉和显示界面进行的通信。

这个汽车和手机行业是类似,手机1.0时代按键交互,手机2.0时代大屏交互但总体来讲都是显性交互,当代手机配合穿戴设备开启了多传感器隐性和显性交互新时代。

我们先开始讲隐式交互智,能汽车识别驾驶员和乘客的行为和活动对车载交互系统和安全功能具有深远的影响。如果正确分类了驾驶员的意图,则可以在每个时刻将人机交互引导到最合适的模态(视觉/听觉/触觉)。例如如果汽车知道乘客的全身姿势(坐姿、躺姿等),安全功能(例如安全气囊、转向、制动和防撞模式)可以根据最佳及时部署进行定制。在检测到驾驶员分心或疲劳时,智能车辆助手可以选择提供视觉或振动警报。此外,智能车辆助手还可以与驾驶员进行对话以保持他们的警觉。

如果检测到非最佳的身体姿势,驱动的内部可以将驾驶员推向正确的身体姿势,以获得最佳的驾驶注意力。同样,如果发现驾驶员的情绪是愤怒或悲伤,智能车辆助手可以推荐舒缓的音乐,控制车内温度,营造轻松的环境。

此外,如果发现驾驶员无法控制车辆,自动驾驶汽车可以脱离驾驶员,将驾驶员带到安全地带,并与附近的其他车辆 (V2V) 和相关机构 (V2X) 进行通信。

等等毕竟人很奇怪的心理需求是需要别人懂,而隐式交互却是让机器懂你的方式。

本文讲大抵介绍隐式交互的三部分:

与安全直接相关的疲劳和分心识别,通过现有驾驶员检测和车辆动态状态传感器配合AI算法交互

情绪识别,通过生理传感器配合AI算法

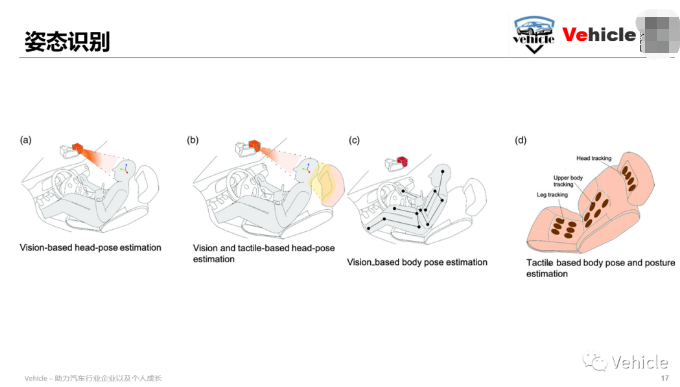

姿态识别,通过视觉传感器配合AI 算法,触觉传感器希望能给大家一些信息和启发

疲劳和分心识别

驾驶员分心是道路事故的主要原因之一,美国国家公路交通安全管理局 (NHTSA) 估计高达 25% 的道路事故是由于某种形式的驾驶员分心而发生的。驾驶员分心或注意力不集中可以定义为“驾驶员注意力不集中表示在没有竞争活动的情况下对安全驾驶至关重要的活动的注意力减少。”分心和疲劳是导致驾驶事故的驾驶员注意力不集中的两种常见形式。

先前的工作已经确定了分心类型的各种区别,例如在路上用手(手动)、眼睛(视觉)和/或头脑(认知)执行第二或第三任务。虽然这些是分心的主要来源,但也可能有其他输入,例如导致分心的听觉刺激。此外,一些活动可能是不同类型的干扰(如发短信)的组合,而驾驶则是手动、视觉和认知干扰的组合。为了检测驾驶员分心,第3节讨论了各种传感技术 . 我们讨论了使用不同传感技术所采用的相关方法和算法,并在本节中讨论了融合一种或多种传感信息的方法。

车辆 IMU、GPS 和外部摄像头等外部传感器可用于推断驾驶行为和不稳定驾驶模式,这可能意味着分心。车速是一项至关重要的测量,在推断干扰时必须与其他传感器测量一起使用。具有 YOLOv4 和 Faster R-CNN等架构的深度神经网络 (DNN)已与外部摄像头一起用于检测交通中的其他车辆和行人以及路标。识别车道和车道保持错误可以作为检测驾驶员分心的指标。例如,逻辑回归模型已被用于区分分心驾驶和使用车道保持错误的正常驾驶。方向盘传感器还提供驾驶员分心的间接指示。

已经演示了一种通过二阶泰勒级数和观察到的角度来预测转向角以计算转向误差的方法。当驾驶员分心时,错误会增加。相比之下,诸如立体摄像头、红外摄像头、ToF 传感器和 RGB-D 传感器等内部视觉传感器已被广泛用于识别驾驶员和乘客的活动、意图和行为。已经比较了用于检测驾驶员分心的最先进的神经网络架构,例如 VGG、AlexNet、GoogleNet 和 ResNet,并且 ResNet 架构似乎优于其他竞争策略。即使是基于单一图像的驾驶员活动识别来检测诸如打电话、发短信、眼睛偏离道路、揉眼睛等活动,也已经使用神经网络进行了演示。

已经提出了一种基于预训练的 CNN VGG-19 架构的端到端网络,该网络对亮度、阴影、相机姿势和驾驶员种族具有鲁棒性,以检测驾驶员分心。此外,面部的聚焦区域也可用于检测分心,例如打哈欠可能意味着疲劳、眼睛偏离道路、眼睛跟踪、眨眼频率等。与 DNN 相比,支持向量机 (SVM) 等机器学习技术也已用于检测闭眼。为了解决稀疏标记数据问题,已经探索了一种称为少数镜头自适应凝视估计 (FAZE) 的新框架,该框架能够学习凝视、头部姿势和外观的紧凑的个人特定潜在表示。然后利用注视估计对分心驾驶和正常驾驶行为进行分类。

内部摄像头也可用于检测手离开方向盘的活动。检测疲劳和分心的其他指标包括闭眼百分比 (PERCLOS)、眼睛离开道路时间、以及使用来自 RGB 相机的视频序列的打哈欠和点头。此外,红外摄像机可用于减轻照明条件的变化。除了视觉传感技术,生理可穿戴传感器,如肌电图 (EMG)、脑电图 (EEG)、心电图 (ECG)、皮肤电活动 (EDA)、眼电图 (EOG) 和心率传感器也已用于检测分心。通过训练 SVM 分类器,EEG 信号可以分为四类,从警觉到嗜睡。

由于 EEG 测量需要将电极放置在驾驶员的头部,因此它们的实际用例很少;但是,某些新颖的入耳式 EEG 可能会用于实际用例。心电图测量心脏的电活动,驾驶员的情绪、心理活动和体力消耗会影响心率。EOG 传感器用于记录眼球运动,并可用于检测疲劳和嗜睡。例如,当眼睛的上眼睑和下眼睑之间的接触持续约 200-400 ms 时检测到眨眼,如果眼睛保持闭合超过 500 ms 时检测到微睡眠,并且可以通过 EOG 检测到。研究表明,在疲劳开始时,EMG 信号的幅度逐渐减小,可以通过 EMG 设备检测到。生理传感器本质上是侵入性的,这抑制了它们的实际使用。然而,诸如 Neuralink 脑机接口之类的新技术,其中将无线设备直接植入颅骨,可能会提供大脑活动和认知分心的细节,这可以帮助驾驶以及高度自动驾驶。

情绪识别

情绪识别对于决策、沟通、一般情绪、动机甚至驾驶的日常功能至关重要。情绪识别是一个复杂的研究领域,需要使用生理传感器和受控研究,从而增加了车载驾驶员情绪识别的复杂性。情绪识别还可以帮助检测已在第上节中讨论的驾驶员分心和疲劳,但也可以引出有关驾驶员行为的更多信息,并有助于实现理解驾驶员并做出响应的智能车辆的目标.

情绪可以分为六类:愤怒、厌恶、快乐、悲伤、惊讶和恐惧。已经进行了关于驾驶员情绪识别的研究,以识别六种主要情绪或较小的子集,例如愤怒和快乐。借助来自 RGB 或 IR 相机的带注释的头部和面部数据集,监督学习技术可用于对情绪进行分类,例如 k 近邻 (kNN) 、SVM 、和DNN 。这些研究提供了帧级预测以及窗口级,其中使用投票方案聚合了不同的帧级预测。相反,使用生理信号,使用各种生理传感器提取高维信号。因此,降维算法如主成分分析(PCA) 和线性判别分析 (LDA) 被使用。

PCA 有助于找到一组不相关的特征来解释原始数据的差异,而 LDA 用特征的线性组合拟合数据,同时找到区分类别的线性函数。在降维时,使用的流行方法包括支持向量机和朴素贝叶斯,用于监督学习以对情绪进行分类。由于生物物理数据由时变信号组成,因此可以从时变信号中捕获特征的循环神经网络在情感识别方面表现出良好的性能。

语音信号也用于情绪识别,因为语音可以提供线索,用于破译驾驶员的情绪。语音信号还包括需要降维技术的高维信号,例如生物物理信号。研究还表明,语音信号的特征(如音调、能量和强度)对于情绪识别很有用。驾驶员的情绪状态也可以通过驾驶员的情绪状态来推断,例如当驾驶员高兴或生气时,方向盘上的握力会发生变化。为了确定检测挫折的最佳框架,对五种不同的监督学习算法及其组合(贝叶斯神经网络 [BNN]、SVM、高斯混合模型 [GMM]、多项回归 [MNR] 和 GMM + SVM)进行了比较。结果表明,SVM 和 MNR 在从驾驶员坐姿检测挫败感的任务中表现最好。

姿态识别

对于交互、安全和分析驾驶员或乘客的活动,跟踪身体部位和身体运动学(例如头部姿势、身体姿势、手、脚和躯干的位置、婴儿的存在等)至关重要。从驾驶的人体工程学角度来看,驾驶员姿势监测也很重要。研究表明,在长途驾驶中,不良姿势会导致驾驶员不适。因此,除了前面讨论的关于活动、情绪和分心检测的部分之外,还要单独分析姿势识别。

如上图 6a所示,头部姿势估计和跟踪对于各种用例至关重要,例如驾驶员监控、分心检测、凝视检测、头戴式设备校准等。模板匹配方法已被证明可用于头部姿势估计和跟踪。使用 RGB 图像上的特征提取技术检测头部区域,然后将其与训练数据中的示例头部图像进行匹配。示例图像的姿势是估计的头部姿势。类似地,通过使用量化姿势分类器的从粗到细的策略来检测离散的头部偏航和俯仰值。还可以通过跟踪关键面部特征(例如眼角、鼻尖和鼻角)来估计头部姿势。当面部处于全正面视图时,该方法表现出良好的性能。

由于它基于基于单目相机的方法,因此性能会因单一视角、遮挡或大运动的存在而降低。为了解决 RGB 相机的照明问题,已经设计了基于 IR 相机的方法。例如,一种名为 Head Orientation Network (HON) 和 ResNetHG 的新型网络被设计用于从 AutoPOSE 数据集中的 IR 图像估计头部姿势。单目估计对快速的头部运动很敏感,这可以通过在驾驶员的视野中放置多个摄像头来解决。结构光深度相机也被提议用于驾驶员姿态估计,如上图 6c所示。可以通过一种基于图形的算法,该算法使用一系列深度帧将 7 点骨骼模型拟合到驾驶员的身体。同理,飞行时间深度传感器(FoT也就是激光和雷达类传感器)已被用于估计驾驶员四肢的位置和方向,包括手臂、手、头部和躯干。迭代最近点 (ICP) 算法用于使用人体关节 3D 模型进行姿势估计。

然而,众所周知,ICP 陷入局部最小值,需要良好的初始猜测来执行姿态估计过程。除了视觉传感器,触觉传感器(如力传感器阵列、触觉传感器皮肤和接近传感器)也已用于身体姿势和头部姿势估计,如图 6b、d所示。正如智能座舱系列文三- 它背后的5种交互技术之触觉。中详细讨论的那样,触觉传感阵列可以不显眼地无缝集成到座椅中。例如,在靠背和坐垫上带有分布式压力传感器的座椅已被用于测量驾驶员的坐姿。座椅上的这种力传感阵列已用于测量驾驶员和乘客的身体姿势,以用于安全关键应用,例如安全气囊展开。

同样,与 IMU 测量融合的压力图已被部署以稳健地识别身体姿势。具有电容式接近传感器的传感头枕已被用于头部姿势估计和头枕伺服,其中头枕可以使用基于非参数神经网络的方法根据用户头部的移动而移动。其他作品展示了传感器,例如嵌入头枕中用于头部姿势估计的超声波传感器。然而,为了稳健地估计身体和头部姿势,触觉传感器需要以多模式方式与视觉传感器相结合。

总结

隐式交互在智能驾驶舱方面,应该属于刚刚萌芽的阶段,他关系到了各种传感器的应用,有当前激光和雷达产业,有视觉摄像头产业,也有穿戴生理传感设备产业方面。属于一个很大的市场,当然这些背后同样少不了AI 人工智能的支持,这个和智能驾驶类似。

参考文章

智能座舱技术 - Prajval Kumar Murali, Mohsen Kaboli,* and Ravinder Dahiya*

*未经准许严禁转载和摘录