知情郎·眼|

侃透天下专利事儿

今年的谷歌开发者大会(Google I/O 2022)上有什么新玩意、硬科技?

谷歌翻译、谷歌多重AI搜索、保护性计算、Android 13、谷歌硬件。

在2小时的主题演讲上,谷歌梳理了自己现有AI计算的进度,并演示了关键技术应用。并发布了谷歌手机,还提前曝光了谷歌AR眼镜!

有不少最新技术理念和硬核产品,科技圈媒体已经铺天盖地报道了。

01谷歌的逻辑

一家高科技公司总要有句通俗易懂的口号,方便和用户直接交流。

曲高和寡、孤芳自赏装深沉装睿智是行不通的。

谷歌CEO桑达尔·皮查伊(Sundar Pichai)很懂这思路,所以他的口号从来简明扼要。

这次他的口头禅是:“谷歌的目的,深化用户对信息的理解,让人们无论在哪都能获得知识。”

桑达尔·皮查伊印度平民家庭出身、买不起新书包的穷学生,一路爬到谷歌寡头公司的CEO,皮查伊的成功充满了励志色彩,激励着世界许多寒门子弟奋发前进。

Google搜索引擎、谷歌Chrome、Chrome OS、地图、Gmail、Android都是在他的带领下壮大的,人称劈柴哥!

谷歌的工程师文化在他手里被发扬到了极致,一个重要的行事规则是——杀鸡要用牛刀,集重兵狂投入优化产品功能性到极点。

Chrome浏览器就是这个逻辑的经典产品,核心功能细节比同行强的时候,用户蜂拥而至。

工程师文化,就是这点好,拼产品功效功能细节,没有花哨,比不过别人就是比不过别人,没有废话连篇的自我遮羞布。

市场用户最公平,不管竞争是否激烈,不管条件是否艰苦,不管舞台大小,不看你演戏演技演给谁看。

就看产品本身实用性说话。

不行,千万别浪费观众时间,大家都不傻,烦了,人家真会扔臭鸡蛋香蕉皮砸人的。

02谷歌翻译、谷歌地图

在翻译领域,谷歌已经要超神!

谷歌宣布,谷歌翻译增加了对24种新语言的支持,深度神经网络算法功不可没!

大概全世界所有主流语言都能支持翻译了。

在视频领域,YouTube视频已经支持了16种语言的实时翻译。YouTube去年已经可以自动生成章节分段。现在通过语音/视频脚本分析等,让这种分段更准确,数量也会达到8千万段。

在NLP(自然语言处理)领域,谷歌的AI技术可以对文字段落进行更好的理解、总结,并帮助用户快速找到重点信息。

谷歌地图(Google Maps),进一步完善了地图数据,谷歌的心气自然是让全世界都能用谷歌地图,所以这次人家表态,已经能让非洲等偏远地区使用了。

有一说一,谷歌地图的细节处理非常优秀。据官方说,已经开始大规模应用3D航拍、AI智能等技术,以此来确保导航、搜索等功能的准确性。

同时,3D绘图和机器学习等+航拍,让沉浸式实景地图更逼真完整。

会上,谷歌也公布了关于地图应用的最新数据:已在全球范围内绘制超16亿座建筑和6000万公里的道路。

03多重维度AI搜索

谷歌核心产品是搜索引擎。

2022这产品又添加了什么黑科技功能?

在之前,搜索是类似查询的方式,你输入文字,它给出一堆相应结果。

现在,用户的要求多了,也复杂了。

例如用户会上传一张图片、一段小视频,甚至一段鸟叫声,问图片里、视频里的是什么鸟类?

这种问题不再是文字,而是图片、视频影音、文字的多维度结合。

这就是最新的技术“图像检索+识别”,比传统文字检索识别更难更复杂。

这属于多重搜索,也是谷歌这些年发力的重点。

简单的说,“多重搜索”利用AI多模型理解,去理解人们的搜索意图,并用直观的方式体现。

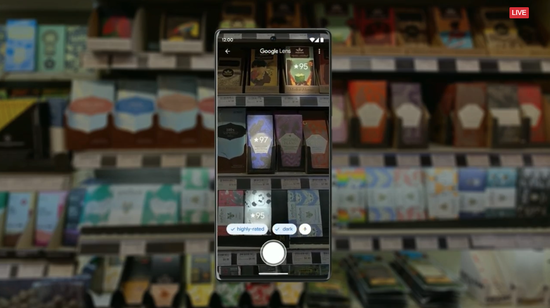

一个实例来说,在巧克力店去寻找“不含坚果黑巧克力”,用户要做的是采用手机镜头去扫描货架,找到指定的产品。

镜头去识别物体-加入筛选条件-呈现出结果。

这是图像识别+筛选结果的过程,仍旧是一种搜索,但已经跟之前的搜索引擎体验完全不同。

整个视频检索体验与以往理解传统文字框搜索很不一样。

知情郎对这搜索应用技术叹为观止。

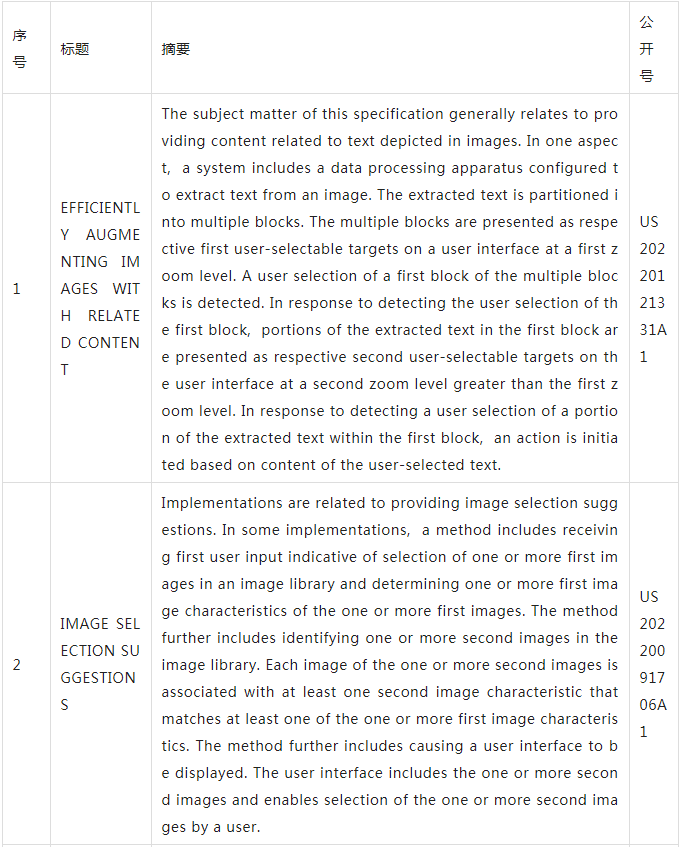

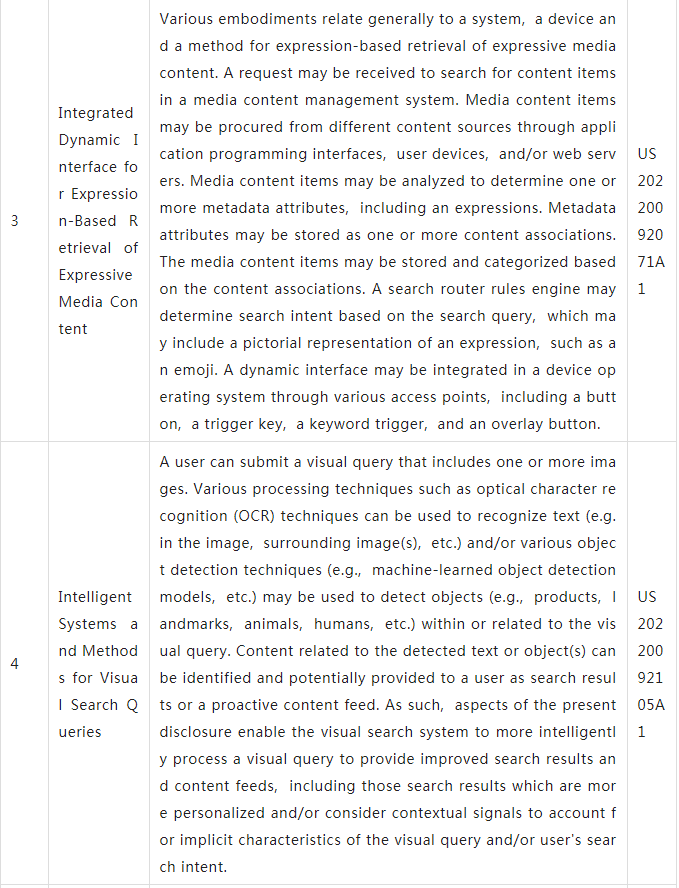

在德高行全球专利数据库中,以图像检索+识别为关键词,在谷歌全球专利里检索了相关专利,以数量看,中国专利60件,包括发明公开32件、发明授权28件;美国专利205件,包括发明公开83件、发明授权122件

下表为9件为谷歌近期公开图像检索+识别领域的专利。

这些专利含金量都非常大,谷歌的目标是“用任何方式在任何地方进行搜索”,所以研究多维搜索,尤其是通过手机自带的摄像头视频拍摄识别这种模式,大概率会成为主流搜索应用之一。

04谷歌AI语音助手Google Assistant

手机带AI语音助手,已经成了行业惯例。

国内比较成熟的就是百度语音助手小度,能帮助用户处理一些简单的操作指令。

谷歌的AI语音助手则是Google Assistant,谷歌称,在AI对话能力技术领域,全球每天有7亿人都在使用Google Assistant。

在开发者大会上,谷歌发布了“Look and Talk”功能,用户不再必须通过“Hi Google”唤醒设备。用户可以通过注视并直接讲话与语音助手进行交流。

你只需要看着设备屏幕上的前置摄像头,并说出需求,语音助手就会进行应答。

另外,用户可以直接通过一些快捷短语控制语音助手,进行一些事项的处理,比如上个闹钟、关个灯。

谷歌的核心目的,就是让用户可以与语音助手交互的更自然。

值得一提的是,在开放式对话处理方面,谷歌进一步优化了神经网络模型,语音助手甚至可以对非连续的对话进行理解。

比如用户说话的时候即使磕巴、语句断断续续,语音助手还是可以听懂用户的意思。

▲AI会去掉语句中的“停顿”和“卡壳”

去年谷歌发布了生成语言模型LaMDA,谷歌今年将其迭代为LaMDA 2,并向一些谷歌员工开放测试。

LaMDA甚至学会了“想象”,比如当用户说,“想象世界上最深的海是什么样子”,LaMDA会找到马里亚纳海沟。

此外,用户还可以与LaMDA围绕某一话题展开讨论,LaMDA会一直围绕这一话题进行回答。

比如讨论关于“狗”的话题,LaMDA的回答都会围绕狗来展开。

谷歌在发布会上也提到了近期发布的PaLM大模型,该模型包含5400亿参数,它可以解答数学问题,甚至可以解释一个笑话。

PaLM可以用没有训练过的语言回答用户提出的问题,打破语言的边界。

谷歌在大会上宣布,他们将为谷歌云客户提供全球最大的开放机器学习中心,该数据中拥有9 exaFLOPS的算力。

另外,Android 13今年发布。

05谷歌手机

大家比较的关心也是这个。

首先是谷歌Pixel 6a,它是旗舰Pixel 6的“青春版”,依旧是谷歌自研芯片Tensor ,也依旧支持5G,还有Android 13系统。

外观设计类似,但看起来没那么高端(应该是塑料材质),背后是1200万像素的双镜头系统,价格更低了只要449美元起,走的是平民廉价路线。

有一说一,谷歌这思路是挺政治正确的,在中高端市场,苹果在美国的统治力过大,死磕没必要,不如学当年的小米,继续走低价倾销策略,专注低端市场扩销量是真。

这手机7月21日预售,7月28日上市。

这款手机跟之前所有Pixel手机一样,是Android系统和刚才讲那一大票AI技术+算法的硬件体现;或者说是谷歌技术的硬件躯壳。

06新款AR眼镜

在开发者大会末尾,公司透露,它正在开发一副新的增强现实智能眼镜,旨在“打破沟通障碍”。

外形和普通眼镜类似,减少了佩戴者的突兀感。

功能方面,谷歌AR眼镜可以直接看到翻译在眼前的语言,非常酷。相当于直接给你加字幕解读外文影视剧!

但谷歌没有透露该设备的具体名称,也没有说什么时候会向消费者发布。

谷歌AR眼镜天天在讲故事,讲了好多年,就是没看见好的应用产品,大家等的黄花菜都凉了。

这行业竞争也激烈,Meta、苹果、三星、微软等科技巨头都陆续透露正在研究或者即将推出AR眼镜产品。

不过,据媒体报道,谷歌之前收购了Raxium,这是一家专注于开发针对AR/VR/MR设备应用的单片集成式RGB Micro LED微显示器公司,很明显,谷歌收购这家公司也是为了提高AR设备的适用性,看来,这次人家有备而来。

知情郎专门查了下公司专利,在德高行全球专利数据库中,关于google的AR眼镜专利,中国专利43件,包括发明公开21件、发明授权7件、外观设计15件。美国专利124件,包括发明公开60件、发明授权57件、外观设计7件。

看了眼谷歌4月底公布的最新智能眼镜专利,这专利除了赋予眼镜用户传统的所示视图外,还增加了将信息(例如,数字图像)叠加至视场并基于例如光学头戴式显示屏(OHMD)、兼具透明头戴式显示屏(HUD)嵌入式无线眼镜进行AR视图覆盖,总而言之,现代智能眼镜实际上可以是运行独立移动应用程序的可穿戴电脑,并能支持用户通过免提、自然语言语音命令以及触屏功能按钮与互联网通信。

外媒的原话是:谷歌正在开发的智能眼镜兼具了AR功能,可呈现融合了真实和虚拟图像的增强现实视图,与谷歌之前推出的智能眼镜相比,显然这款眼镜具有更好的性能,其配置的高质量摄像头模块和3D传感模块将在虚拟图像与现实世界的融合中发挥着关键作用。

至于现实效果,谁用谁知道!没见过成品,啥都不说!

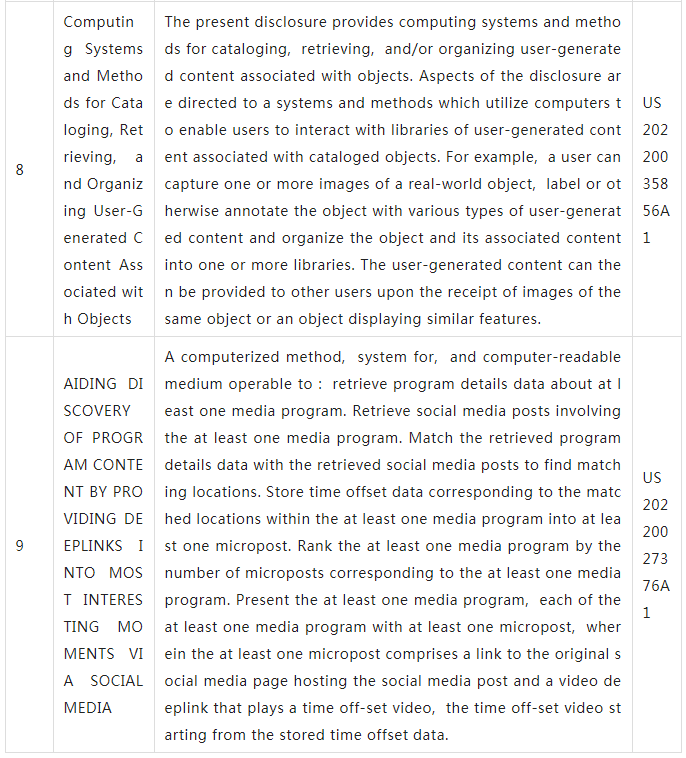

07视觉搜索查询的智能系统

分享个谷歌AI搜索技术研发方面的最新专利,视频检索+识别是它最新发力点。

一般而言,本公开涉及一种计算机实现的视觉搜索系统,可以用于检测 和识别视觉查询中的对象或与视觉查询相关的对象,然后提供响应视觉查询 的更个性化和/或智能的搜索结果(例如,在增强视觉查询的覆盖中)。

例如, 用户可以提交包括一个或多个图像的视觉查询。在视觉查询中或与视觉查询 相关,各种处理技术(诸如光学字符识别(OCR)技术)可以用于识别文本 (例如,在图像、周围图像中等)和/或各种对象检测技术(例如,机器学习 对象检测模型等)可以用于检测对象(例如,产品、地标、动物、人类等)。

可以识别与检测的文本或对象(或多个)相关的内容,并可以将其作为搜索 结果提供给用户。因此,本公开的方面使得视觉搜索系统能够更智能地处理视觉查询以提供改进的搜索结果,包括更个性化和/或考虑情境信号的搜索结 果来解释视觉查询和/或用户搜索意图的隐式特征。

本公开的示例方面响应于视觉查询提供了更智能的搜索结果。

视觉查询 可以包括一个或多个图像。例如,在视觉查询中包括的图像可以是同时捕获 的图像,也可以是先前存在的图像。

在一个示例中,视觉查询可以包括单个图像。在另一示例中,视觉查询可以包括来自大约三秒视频捕获的十个图像 帧。

在又一示例中,视觉查询可以包括图像的图像库,例如,包括在用户的 照片库中的所有图像。

例如,诸如库可以包括用户最近捕获的动物园动物的 图像、用户不久前捕获的猫的图像(例如,两个月前)以及用户从现有来源 (例如,从网站或屏幕捕获)保存到库中的老虎的图像。这些图像可以代表 用户的一组高亲和力图像,并体现(例如,通过图形)用户可能对类似动物 的事物具有“视觉兴趣”的抽象想法。

任何给定的用户都可能有许多这样的节点集群,每个节点集群代表的是无法很好地被词捕获的兴趣。

根据一个示例方面,视觉搜索系统可以构建并利用用户中心视觉兴趣图 来提供更个性化的搜索结果。在一个示例使用中,视觉搜索系统可以使用用 户兴趣图来过滤视觉发现通报、通知或其他机会。

因此,在示例性实施例中, 在搜索结果在查询图像的增强覆盖中呈现为视觉结果通知(例如,在某些情 况下可称为“闪光(gleams)”)的示例性实施例中,基于用户兴趣的搜索结 果的个性化可能特别有利。

更具体地,在一些实现中,视觉搜索系统可以包括或提供增强覆盖用户 界面,用于为搜索结果提供视觉结果通知,作为视觉查询中包括的图像的覆 盖。

例如,视觉结果通知可以在和与搜索结果相关的图像部分相对应的位置 提供(例如,视觉结果通知可以显示在与对应搜索结果相关的对象的“顶部”)。因此,响应于视觉搜索查询,可以识别多个候选搜索结果,并且多个候选视 觉结果通知可以分别与多个候选搜索结果相关联。然而,在底层视觉搜索系 统功能强大且范围广泛的情况下,大量候选视觉结果通知可能可用,使得所有候选视觉结果通知的呈现将导致用户界面混乱地拥挤或以其他方式不希望 地模糊基础图像。

因此,根据本公开的一个方面,计算机视觉搜索系统可以 构建并利用用户中心视觉兴趣图来基于观察的用户视觉兴趣对候选视觉结果 通知进行排名、选择和/或过滤,从而提供更直观和简化的用户体验。

在一些实现中,用户特定兴趣数据(例如,可以使用图表示)可以至少 部分地通过分析用户过去参与的图像随时间聚合。

换言之,计算系统可以通过分析用户随时间参与的图像来尝试理解用户的视觉兴趣。当用户参与图像 时,可以推断图像的某些方面是用户感兴趣的。因此,可以在用户特定兴趣 数据(例如,图)中添加或以其他方式标注包括在此类图像中或与此类图像 相关的项(例如,对象、实体、概念、产品等)。

【转载请注明 德高行·知情郎】